エージェントをテストする(品質センター)

AI エージェントをテストして、その動作とパフォーマンスを検証します。

テストにアクセスするには、AI エージェント > 品質センター に移動します。

エージェントは、次の方法でテストできます。

- 手動テスト: メッセージを送信し、応答をすぐに表示します。詳細は、テストメッセージを手動で送信するをご参照ください。

- 自動テスト: 複数のテスト ケースを含むテスト グループを作成し、順番に実行します。詳細は、自動テストワークフローをご参照ください。

手動テスト

メッセージを送信し、応答をすぐに表示して、エージェントをテストします。このオプションは、迅速なテストとデバッグに使用します。

メッセージの送信

-

AI エージェント > エージェント ページで、テストするエージェントを開きます。

-

プレビュー を選択します。

チャット & トレース ウィンドウが開きます。

-

次の手順に従います:

- メッセージを送信して、会話でのエージェントの動作をテストします。

- (オプション)エンドユーザー宛先 で、エンドユーザーの対話をシミュレートするようにテストユーザー番号を構成します。

エージェントがメッセージに応答します。

テスト結果を確認する

テストメッセージを送信したら、次の操作を行います。

- 会話を確認する: エージェントの応答が期待と一致していることを確認します。

- 処理の詳細の表示: 右側のパネルで、処理の詳細を表示します。これには、各イベントのタイムスタンプ、LLM に送信されたリクエスト、LLM からの応答、および結果が含まれます。タイムラインビューまたはツリービューのいずれかを使用できます。

- 有用な会話を保存 (省略可能): 会話を保存 を選択して、テスト ケースで再利用するためにこの会話を保存します。保存した会話をテストグループに追加して、自動テストを行うことができます。詳細については、保存した会話をテストグループに追加をご参照ください。

自動テスト

品質センター を使用して、複数のテスト ケースを含むテスト グループを作成し、それらを順番に実行します。

品質センターのページ

品質センターでは、自動テストを実行して AI エージェントをテストできます。

品質センターにアクセスするには、AI エージェント > 品質センター に移動します。

このページでは、次の操作を実行できます:

-

検索: 検索ボックスを使用して、テスト グループを名前で検索します

-

フィルタ: フィルタアイコンを選択して、エージェントまたは日付別にテストグループをフィルタします

-

テストグループの作成: テストグループの作成を選択して、新しいテストグループの作成

-

テスト グループの表示: テスト グループの一覧を表示します。テスト グループごとに、次の情報を表示できます。

- テストグループ: テストグループの名前

- AI エージェント: テスト グループに関連付けられた AI エージェント

- テスト ケース: グループ内のテスト ケースの数

- 最終実行: 最新のテスト実行の日時

テスト グループごとに、メニュー (3 つのドット) から次の操作を実行できます。

- 重複したテストグループ: テストグループのコピーを作成

- 削除: テスト グループを削除します

自動テストワークフロー

テストグループを使用してエージェントをテストするには、次の手順に従います。

- テストグループを作成する: AI エージェントのテストグループを設定します。

- テストケースの追加: テストケースを手動で作成するか、CSV からインポートするか、保存した会話を追加して、グループに追加します。

- テストグループの実行: テストグループを 1 回または複数回実行して、整合性を確認します。

- 結果を見る: 合格/不合格の結果を確認し、予想される動作と実際の動作を比較し、問題を特定します。

次のセクションでは、各手順について詳しく説明します。

テストグループを作成する

テスト グループは、関連するテスト ケースを整理します。各テスト グループは 1 つの AI エージェントに関連付けられ、複数のテスト ケースを含めることができます。1 つのエージェントに対して複数のテストグループを作成できます。

テストグループを効果的に整理するためのガイダンスについては、テストのベストプラクティスを参照してください。

新しいテストグループは、手動で作成することも、既存のテストグループを複製して作成することもできます。

テスト グループを手動で作成する

- 品質センターで、テスト グループの作成 を選択します。

- [新しいテスト グループ** ウィンドウで、以下を構成します。

- エージェント: テストするエージェントを選択します。

- テストグループ名: テストグループのわかりやすい名前を入力します。

- テスト グループの作成 を選択します。

これで、テストケースを追加](/ai-agents/build/test-agent#add-test-cases-to-a-test-group)をグループに追加できます。

既存のテストグループを複製する

既存のテストグループを複製して、テストケースを再利用できます。

次の手順に従います:

- テスト グループの一覧で、テスト グループの横にあるメニュー (3 つのドット) を選択します。

- 重複するテスト グループ を選択します。

- 開いたウィンドウで、必要なエージェントを選択します。

- Duplicate (複製) を選択します。

テスト グループ ページ

テストグループを開くと、テストグループページにそのグループのすべてのテストケースが表示されます。

このページでは、次の操作を実行できます:

-

検索: 検索ボックスを使用してテスト ケースを検索します

-

フィルタ: フィルタのテストケース

-

テスト ケースの追加: テスト ケースの追加 を選択して、新しいテスト ケースを追加します。

-

テストケースの表示: テストケースのリストを表示します。テスト ケースごとに、次の情報を表示できます。

- ユーザー入力: テスト ケースの最初のエンド ユーザー メッセージ

- 会話のターン数: エージェントとエンドユーザーの間で交換されたメッセージの数

テスト ケースごとに、メニュー (3 つのドット) を使用して次の操作を実行できます。

- 編集: テストケースを更新

- 複製: テストケースのコピーを作成

- 削除: テストケースを削除

テスト グループへのテスト ケースの追加

テストグループを作成したら、テストケースを追加して、エージェントの予想される動作を定義します。テスト ケースには、エンド ユーザーと AI エージェント間の会話の例が含まれています。

テストケースに含める内容のガイダンスについては、テストケースの要件を参照してください。

テストケースは、次の方法で追加できます。

- 手動

- テスト ケースを含む CSV ファイルをアップロードする

- 保存した会話をテスト ケースとして追加する

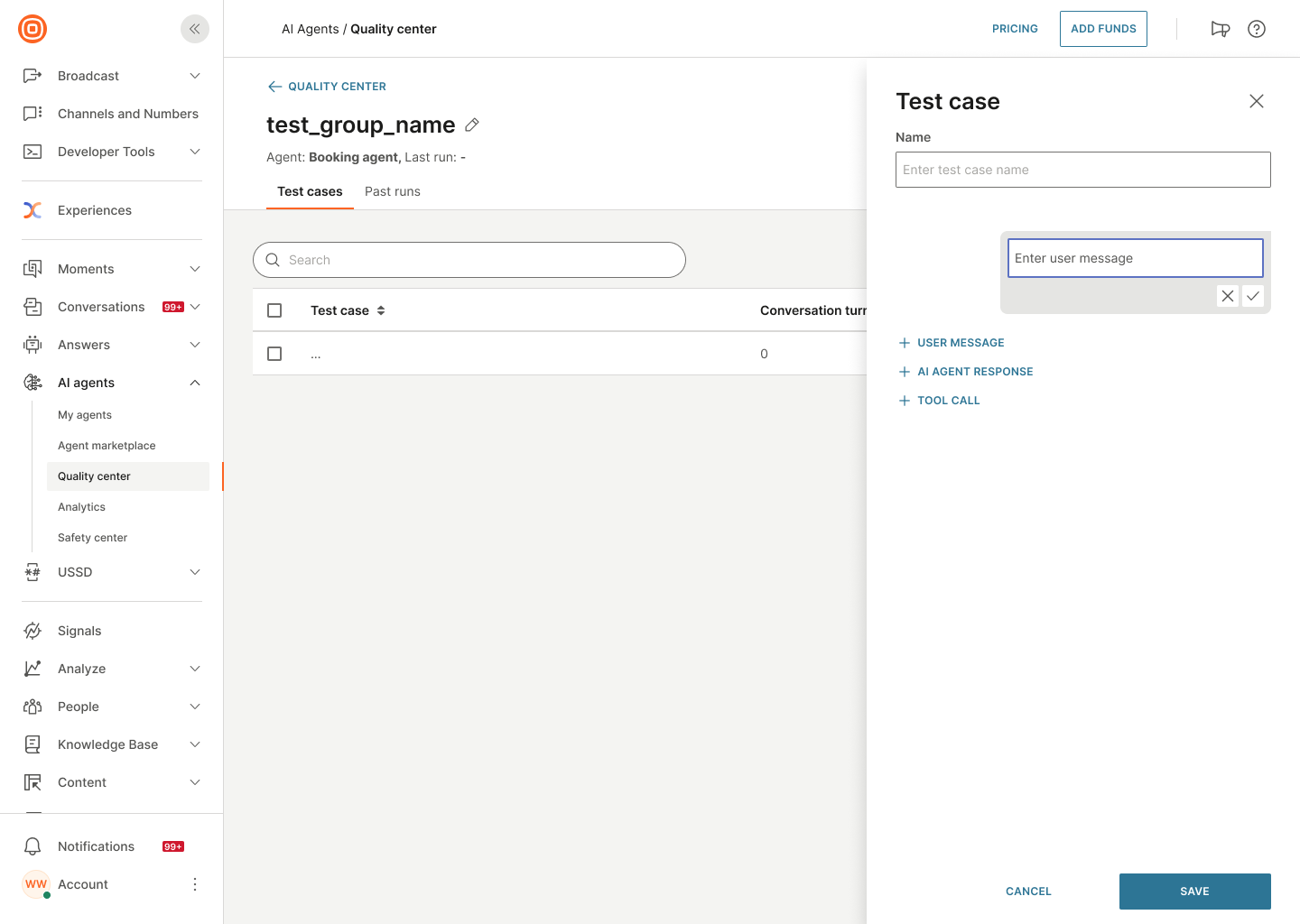

テスト ケースを手動で作成する

会話を手動で構成して、テスト ケースを作成します。

-

テスト グループ ページで、テスト ケースの追加 を選択します。

-

右側のパネルで、エンド ユーザー メッセージの例を入力し、チェックマークを選択します。

-

次の 1 つ以上を実行して、予想されるエージェント応答を追加します。

- エージェントメッセージを手動で入力します。AI エージェントの応答 を選択し、チェックマークを選択します。

- ツールまたはサブエージェントを使用して応答を生成します。ツールコールを選択し、リストからツールまたはエージェントを選択します。

-

会話の作成を続行します。エンド ユーザー メッセージを追加し、予想されるエージェントの応答を追加します。会話全体を通してこのシーケンスを繰り返します。

Note複数の連続したエージェント応答を追加しないでください。

-

(オプション)会話内のメッセージ、ツール、またはサブエージェントごとに、次の操作を実行できます。

- メッセージを変更するか、別のツールまたはサブエージェントを選択する: 鉛筆アイコンを選択します。

- メッセージ、ツール、またはサブエージェントを削除する: [削除] アイコンを選択します。

- 現在のメッセージ、ツール、またはサブエージェントの下に新しいメッセージ、ツール、またはサブエージェントを追加する: プラス記号 (+) を選択し、必要なオプションを選択します。

-

テスト ケースが完了したら、 [保存] を選択します。

CSV からテスト ケースをインポートする

CSV ファイルを使用して複数のテスト ケースをインポートします。

- テスト グループ ページで、メニュー (3 つのドット) を選択します。

- [CSV からインポート] を選択します。

- CSV ファイルをアップロードします。

ファイルのテスト・ケースがテスト・グループに追加されます。

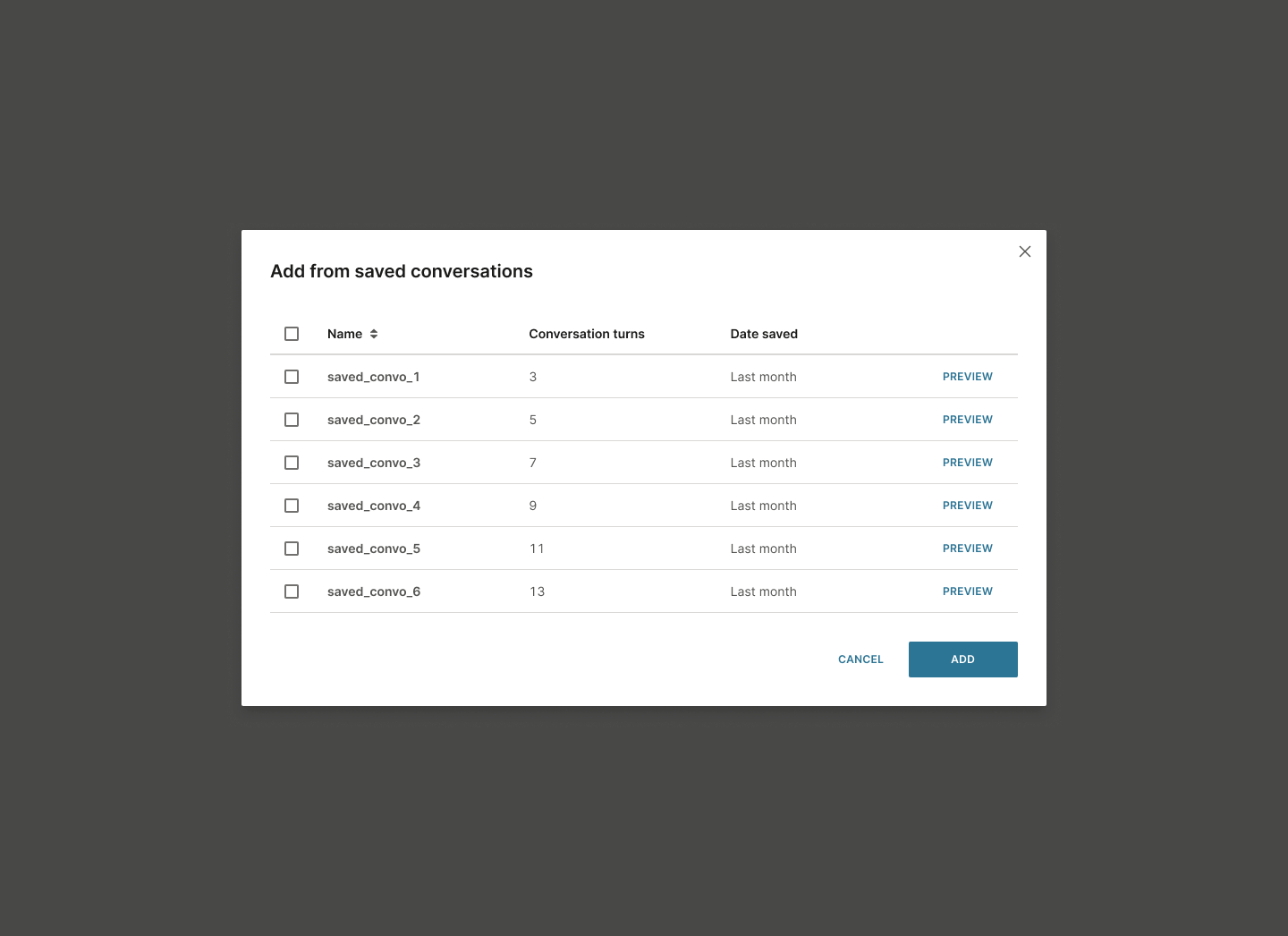

保存した会話から追加する

手動テスト中に保存した会話を使用します。

-

テスト グループ ページで、メニュー (3 つのドット) を選択します。

-

[保存した会話を追加] を選択します。

ウィンドウが開き、保存されている会話のリストが表示されます。

-

利用可能な会話を確認します。次の情報が表示されます。

- 名前: 会話名

- 会話のターン数: エージェントとエンドユーザーの間で交換されたメッセージの数

- 保存日: 会話が保存された日付

-

[プレビュー] を選択して、追加する前に会話を表示します。

-

必要な会話を選択します。

-

Add (追加) を選択します。

選択した各会話は、個別のテスト ケースとしてテスト グループに追加されます。

テスト グループでテスト ケースを実行する

テスト グループでテスト ケースを実行して、エージェントの動作を検証します。テストケースを複数回実行して、一貫性と信頼性を確保できます。

テスト ケースを実行するには、次の操作を行います。

-

実行するテストグループを開きます。

-

テスト グループの実行 を選択します。

-

開いたウィンドウで、以下を設定します。

-

AIエージェントのバージョン:テストするエージェントのバージョンを指定します。

-

実行回数: テストグループを実行する回数を指定します。

最大 10 回の実行を指定できます。デフォルト値は 1 です。

Why multiple runs?テストを複数回実行して、エージェントの応答がさまざまな実行で一貫性があり、信頼性が高く、正確であることを確認します。

-

-

テストの実行 を選択します。

これにより、テスト グループ内のすべてのテスト ケースが実行されます。

テストの実行中は、現在の実行を示す進行状況インジケーターが表示されます。例: 1/5 の実行。

テストが完了したら、テスト実行に移動 を選択して結果を表示します。

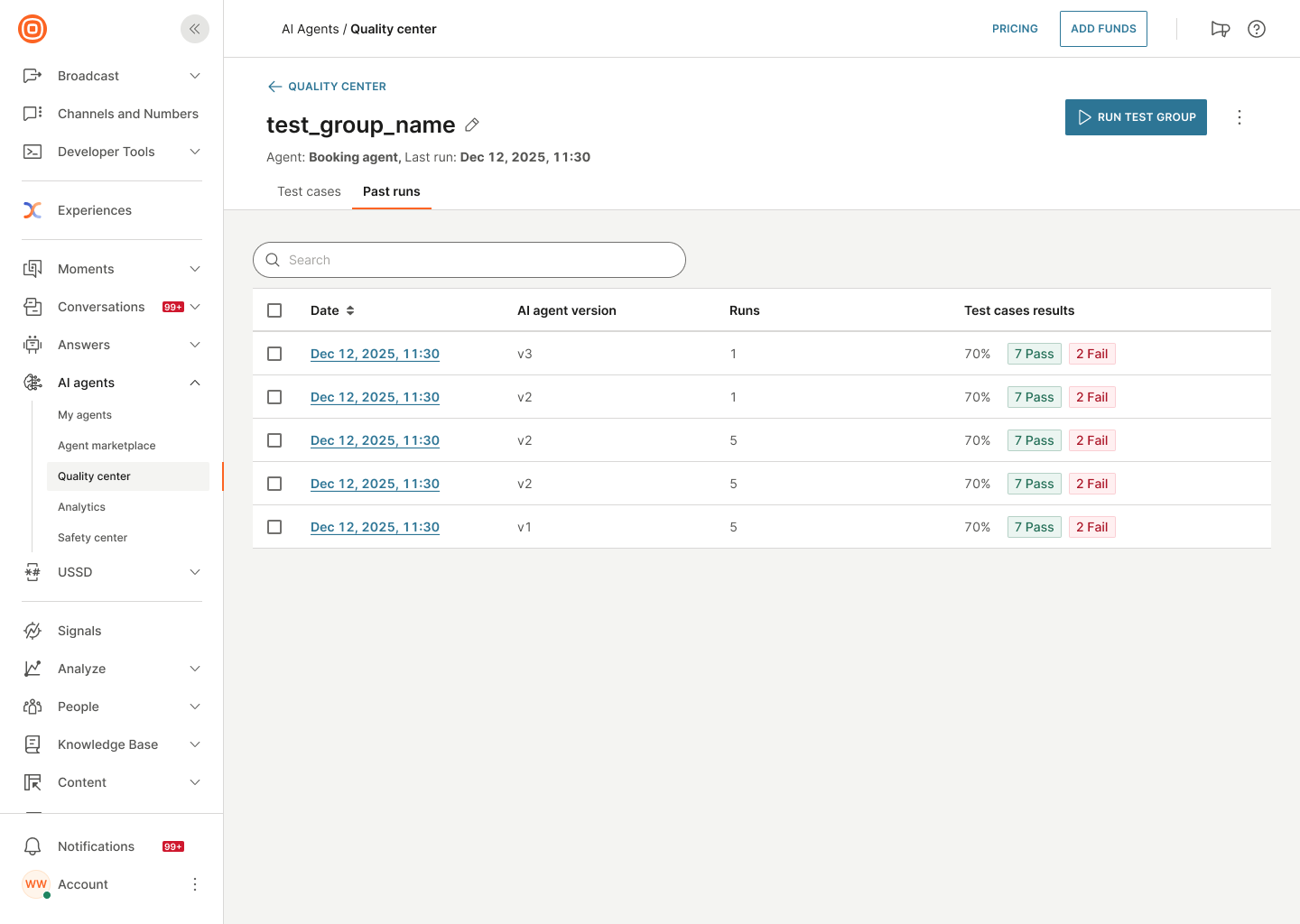

[過去の実行] タブ

テスト グループに移動し、[実行] タブを選択すると、[過去の実行] タブに、そのテスト グループのすべてのテスト実行が表示されます。

このページでは、次の操作を実行できます:

-

検索: 検索ボックスを使用してテスト実行を検索します

-

テスト実行の表示: テスト実行のリストを表示します。テストの実行ごとに、次の情報を表示できます。

- 日付: テスト実行が実行された日時

- AI エージェントのバージョン: テストされたエージェントのバージョン

- テスト ケースの結果: テスト結果の概要で、割合、合格したテスト ケースの数、失敗したテスト ケースの数を示します。例: 70%、7 合格、2 不合格

実行中のテストの場合、テスト ケースの結果 に 進行中 と表示されます。

- テスト実行の並べ替え: 並べ替えるテーブル ヘッダーを選択します。

テスト実行を選択して詳細な結果を表示します。

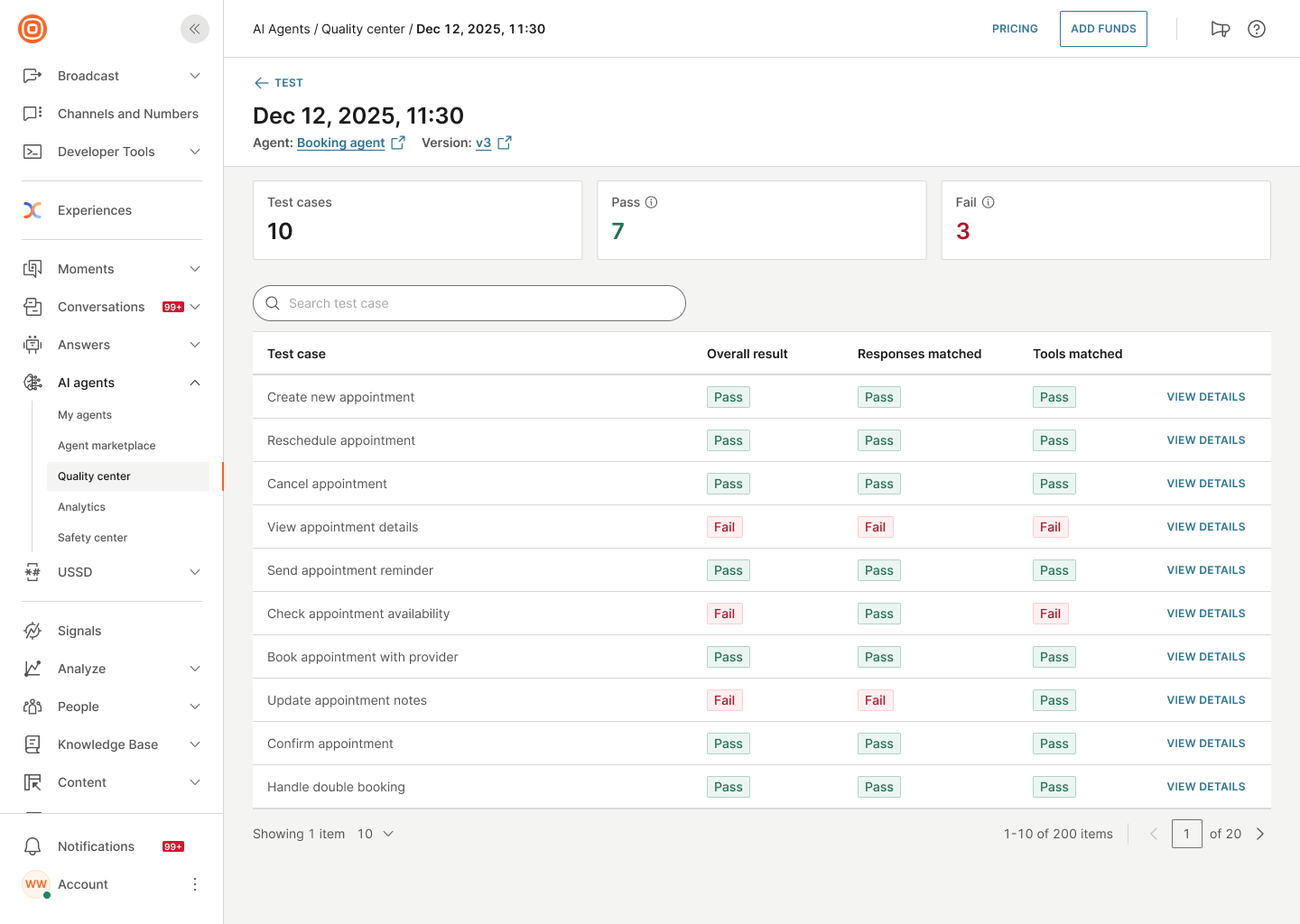

テスト結果の表示

テスト結果を確認して問題を特定し、エージェントの動作を確認します。

テスト結果を表示するには:

- テストグループに移動します。

- [過去の実行] タブに移動します。

- 確認するテスト実行を選択します。

テスト ケースの詳細を表示する

確認するテスト実行を見つけます。また、テスト実行を日付で並べ替えたり、[検索] ボックスを使用したり、[フィルタ] アイコンを使用して必要なテスト実行を見つけたりすることもできます。

詳細を表示するテスト実行の日付を選択します。例: 2025 年 12 月 12 日 11:30。

次の情報を表示できます。

全体的なパフォーマンス: テスト実行全体の合格/不合格数を確認します。

- テスト ケース: テスト ケースの総数

- 合格: 合格したテスト ケースの数。エージェントは必要なツールを呼び出し、正しい答えを与えました。

- Fail: 失敗したテストケースの数。エージェントが必要なツールを呼び出さなかったか、間違った回答をしました。

各テスト ケースについて、次の詳細を表示します。

- ユーザー入力: テスト ケースの最初のエンド ユーザー メッセージ

- 全体的な結果: 合格または不合格

- 一致した回答: 合格または不合格

- 一致したツール: 合格または不合格

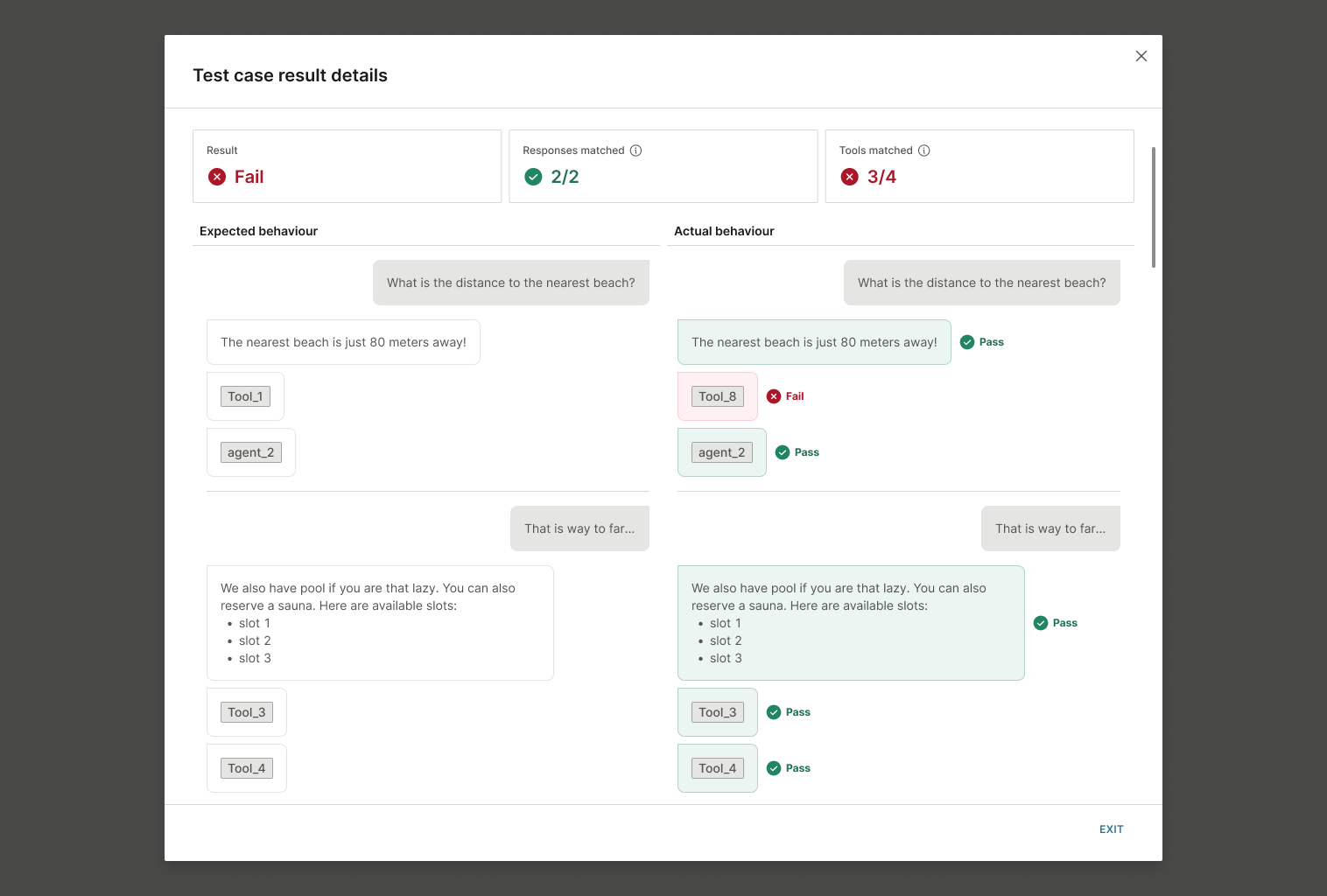

テスト ケースの詳細を表示する

注: エージェント メッセージ、ツール コール、またはサブエージェント コールが 1 つでも予期される動作と一致しない場合、テスト ケースは失敗します。

-

表示するテスト ケースの [詳細の表示] を選択します。

-

集計された概要を確認します。

- 結果: 全体的な合格または不合格ステータス

- 一致した応答: エージェントの応答が予想される応答と一致したかどうか。ナンバーマッチング(例:2/2)

- 一致したツール: ツールとエージェントの通話が期待に合ったかどうか。番号の一致 (例: 4/4) - 合格または不合格。

-

予想される動作と実際の動作を比較します。

- 予期される動作 (左の列): 構成したテスト ケース

- 実際の行動(右の列):エージェントが実際にどのように反応したか

-

障害ポイントを特定します。

- 各エージェント メッセージ、ツール コール、およびサブエージェント コールを確認します

- 各エレメントの横にある合格または不合格のインジケーターを探します

- いずれかのエレメントが失敗すると、全体的な結果は失敗します。

- エージェント メッセージが予期された応答と一致しない

- ツール呼び出しが予期されたツールと一致しません

- サブエージェントコールが予期されたサブエージェントと一致しない

-

分析情報を使用して、エージェントまたはテスト ケースを更新します。

複数の実行で結果を比較する

テスト実行に複数の実行がある場合は、各実行の詳細に加えて、全体的な結果を表示できます。

- テスト ケース: テスト グループ内のテスト ケースの合計数

- 合格率: すべての実行で合格したテスト ケースの平均。エージェントは必要なツールを呼び出し、正しい答えを与えました。

- 失敗率: すべての実行で失敗したテスト ケースの平均。エージェントが必要なツールを呼び出さなかったか、間違った回答をしました。

各実行の結果を確認して、整合性の問題を特定します。各テスト実行は、個別のタブにあります。各タブには、テスト実行が成功したか失敗したかを示すインジケーターがあります。

テスト グループの管理

テスト グループを編集する

品質センターで、編集するテストグループを選択します。必要に応じて、テストグループ名を更新するか、テストケースを変更します。

テスト グループを削除する

テスト グループの一覧で、テスト グループの横にあるメニュー (3 つのドット) を選択します。削除 を選択します。

テスト グループを複製する

テストグループの複製については、既存のテストグループを複製するをご参照ください。

テスト ケースの管理

テスト ケースを編集する

テストグループに移動します。必要なテスト ケースに対して [編集] を選択します。

テスト ケースを削除する

テストグループに移動します。テスト ケースの横にあるメニュー (3 つのドット) を選択し、[削除] を選択します。

テストケースを複製する

テストグループに移動します。テスト ケースの横にあるメニュー (3 つのドット) を選択し、複製 を選択します。

テスト・グループ内のテスト・ケースのエクスポート

テスト グループに移動し、エクスポート を選択して、そのグループ内のすべてのテスト ケースを CSV ファイルにエクスポートします。

テストのベストプラクティス

AI エージェントを構築する前にテスト戦略を計画し、エージェントが要件を満たしていることを確認します。

テストグループを効果的に編成する

- グループ関連のテストケース: 機能やユーザー体験ごとに個別のテストグループを作成します

- わかりやすい名前を使用する: テスト グループに明確な名前を付けて、その目的を特定します

- 複数回実行:テストグループを3〜10回実行して、一貫性を検証します

- 有用な会話を保存する: プレビューでの手動テスト中に、重要なシナリオを表す会話を保存します

テストケースの要件

以下を含む包括的なテストケースを作成します。

- 予想されるすべてのユーザー体験: 成功するシナリオと標準的なインタラクション

- 非標準入力: エンドユーザーからの異常または予期しない入力

- ネガティブなシナリオ: API の障害またはデータの欠落

- エラー処理状況: エラーが発生したときのエージェントの応答方法

これらのテスト ケースは、次の目的で使用します。

- 合格基準: AI エージェント システムが機能することを示す

- パフォーマンス ベンチマーク: 品質と効率を測定する

- 回帰テスト: 更新によって既存の機能が損なわれないようにする

評価基準

エージェントの動作を評価するときは、次の点を確認してください。

- 応答の質: テキストは正確で、適切で、役に立ちますか?

- ツールの使用法: 正しい API を呼び出しましたか?正しいパラメータを使用しましたか?

- 推論プロセス: 複雑なタスクを論理的に分解しましたか?

- エラー処理: 障害を適切に管理しましたか?

- 検証手順: アクションを実行する前に結果を正しく処理しましたか?

AI エージェントにとって、正確性とはテキスト出力と操作動作の両方を意味します。明確な出力を生成しても、間違った API を呼び出すエージェントは、依然として機能しません。

次のステップ

テスト結果が期待どおりでない場合は、AI エージェントを更新して問題を解決してください。

テストが終了したら、AIエージェントをpublishします。